Es folgt ein Gastartikel von Pascal Landau

(der sich vorab schonmal für die Länge entschuldigt..)

Das Thema „SEO und URLs“ ist ein typischer Dauerbrenner und wird in verschiedenen Fragestellungen aufgegriffen: „Wie lang darf eine URL sein?“, „Spielt die Anzahl der Verzeichnisse eine Rolle?“, „Wo sollen meine Keywords stehen?“, etc. Auf SEOMoz ist heute ein sehr schöner und ausführlicher Artikel unter dem Namen Should I Change My URLs for SEO? erschienen. Dieser beantwortet nicht nur die Frage im Titel sondern geht auch auf andere common mistakes ein und räumt mit einigen Vorurteilen auf – Grund genug, das Teil mal auf Deutsch auseinanderzunehmen 😉

URLs und SEO – Die Grundlagen

First of all: URLs sind ein wichtiger Bestandteil bei der OnPage Optimierung. Eine erste Einführung dazu gibt es im entsprechenden Unterkapitel zu URLs in meiner ersten Studienarbeit. Darin gehe ich ebenfalls auf einige bekannte Probleme ein und stelle eine „best practice“ Lösung vor. Meist ist es jedoch so, dass viele Leute bereits eine bestehende URL Struktur haben und sich nun fragen, ob sich eine Anpassung lohnt – und gerade bei URLs ist das leider etwas kritischer als beispielsweise die Anpassung der Überschriften.

Soll ich meine URL-Struktur wirklich ändern?

Bevor man die URL Struktur einer Seite ändert, sollte man sich im Klaren darüber sein, dass dadurch in der Regel in der ersten Zeit negative Veränderungen in den SERPs zu erwarten sind. Google muss schließlich erstmal die neue Struktur der Seite komplett Crawlen und den Index entsprechend konsolidieren. Außerdem gibt es keine Garantie dafür, dass die Änderung auch tatsächlich messbar positive Effekte mit sich bringt. Das liegt dann allerdings meist daran, dass die alte Struktur „gar nicht so schlecht“ war und die neue auch nur „ein bisschen besser“ ist.

Dr. Pete bringt in seinem Artikel fünf praktische Beispielfälle, die ich an dieser Stelle aufgreifen und erläutern möchte.

Dynamische URLs

Unter dynamischen URLs versteht man URLs, deren Seiteninhalt über Parameter gesteuert wird. Diese werden durch ein Fragezeichen nach dem Pfad gekennzeichnet. Am Beispiel von WordPress kann man das sehen, wenn man die PermaLink-Struktur bei einer frischen Installation nicht anpasst. Die URLs lauten dann zum Beispiel

http://www.example.com/?p=1417 oder auch

http://www.example.com/?p=1417&category=5.

Probleme dabei:

- Das Keyword ist nicht in der URL enthalten (sowohl aus SEO als auch Usability Sicht schlecht)

- Die URLs werden meist unnötig lang (schon allein dadurch, dass Parameter immer aus &key=value Paaren bestehen und der key redundant ist)

- Sie sind anfälliger für die Erzeugung von Duplicate Content

Die beiden oben genannten Fälle sind natürlich extrem und hier lautet auch klar die Empfehlung, auf sprechende URLs zu wechseln. Es gibt aber auch Beispiele, bei denen die Parameter gar nicht so schlecht implementiert sind. Beispiel:

Auch hier findet eine Steuerung des Inhaltes über Parameter statt, so dass eine dynamische URL vorliegt. Die bessere Variante wäre und bei einer komplett neuen Seite würde man die URL auch so wählen. Bei einer alten, etablierten Seite mit 1000+ Seiten im Index wahrscheinlich nicht, weil die Verbesserung wenn überhaupt nur minimal sein dürfte.

Bottom Line: Was ist bei dynamischen URLs zu tun?

Ich persönlich würde die Struktur ändern, wenn mehr als ein Parameter enthalten ist oder wenn dieser eine Parameter nicht die Keywords der Seite repräsentiert. Bei großen Seiten würde ich das jedoch nur machen, wenn durch die aktuelle Struktur deutliche Nachteile im Ranking festzustellen sind, beispielsweise dadurch, dass so ziemlich alle anderen Faktoren ähnlich optimiert wie bei der Konkurrenz sind, aber der Longtail trotzdem nicht rankt.

Unstrukturierte URLs

Aus informationsarchitektonischer Sicht macht es Sinn, ähnliche Entitäten in Clustern zusammenzufassen und unter entsprechenden Oberkategorien aufzulisten. Übertragen auf URLs würde man also statt

über eine Änderung in

nachdenken. Dr. Pete argumentiert hier damit, dass die zuletzte genannten URLs mehr über den Inhalt aussagen und deshalb augenscheinlich bevorzugt werden könnten (sowohl vom User als auch von der Suchmaschine). Dementgegen spricht, dass das tatsächliche Keyword immer weiter nach hinten rückt. Außerdem ist die zweite Struktur natürlich für Duplicate Content Probleme auf Grund von facetted Navigations anfälliger. Ich sehe allerdings keine messbaren Vor- oder Nachteile.

Übrigens: Die reine Verzeichnistiefe ist kein Argument! Durch Techniken wie mod_rewrite können beliebig viele Verzeichnisse simuliert werden, dadurch ensteht also kein Nachteil. Für Suchmaschinen zählt der Verlinkungspfad, also die Entfernung (sprich die Anzahl der Links, auf die ein User klicken muss) um von der Startseite entsprechenden Unterseite zu gelangen. Das kann sich in der URL Struktur widerspiegeln, ist aber noch lange kein Muss!

Meine persönliche Meinung zu diesem Problem ist die Wahl der zweiten Lösung. Es ist für mich einfach eine Sache der Konsistenz, dass ich meine Inhalte so strukturiere, dass diese Struktur sowohl in der URL als auch in der Verlinkungstiefe repräsentiert wird. Aber: Das ist definitiv kein Kriterium, das ich bei einer Seite ankreiden würde.

Bottom Line: Was ist bei unstrukturierten URLs zu tun?

Die reine Struktur der URL ist kein Kriterium, bei dem sich der Aufwand zur Optimierung lohnt. Hier würde ich nichts ändern sondern darauf achten, dass die Verlinkungsstrukturen entsprechend angepasst sind.

Lange URLs

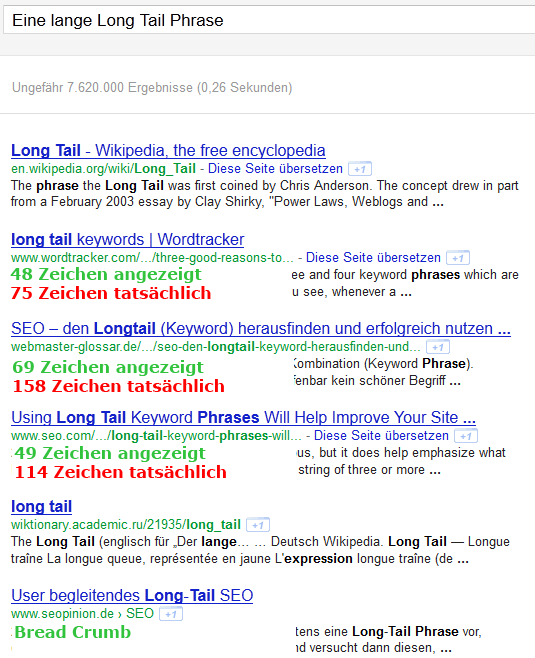

Für URLs gilt das gleiche wie für Titel: So lang wie nötig und so kurz wie möglich. Die Kunst liegt nun darin, die richtige Länge zu finden. Mir ist keine „optimale“ Länge für URLs bekannt, allerdings wird auch die URL im Snippet nach einer bestimmten Anzahl von Zeichen abgeschnitten. Leider gibt es dafür keine konkrete Angabe, weil es zum einen variiert (ich glaube Google achtet hier zum Teil auf Trennzeichen, versucht also keine Wörter in der Mitte abzuschneiden und ersetzt auch gern „Zwischenverzeichnisse“ mal durch /…/) und zum anderen Bread Crumbs angezeigt werden, bei denen die URL gar nicht direkt auftaucht (Beispiel: http://www.google.de/search?hl=de&q=inurl:myseosolution.de/seo-tutorial/).

Generelle Argumente gegen lange URLs sind:

- Je mehr Wörter in der URL sind, desto weniger wird jedes einzelne gewichtet

- Lange URLs sehen blöd im Browser aus und lassen sich schlecht merken (Usability…)

- Können beim Copy & Paste Probleme bereiten

- Manche Social Media Applikationen haben Probleme mit überlangen URLs

Das Problem an sich spielt in die zuvor besprochene URL Struktur mit rein, denn jedes Verzeichnis „verlängert“ die URL. Häufig gibt es auch Redundanzprobleme, wie etwa bei dem folgenden Beispiel:

Gerade dieses Beispiel ist jedoch recht interessant, denn wie würdet ihr die Sache auflösen (anvisiertes Keyword: „Mietwagen Hamburg“)?

Dr. Pete würde Variante 1 bevorzugen, ich würde zu Variante 3 tendieren. Ich kann mich noch schwach an ein Gespräch mit Künstler und SEO Martin Missfeldt auf der Warm-Up Party zur SEMSEO erinnern, bei der es um die Bedeutung des Bildpfades ging. Und wenn ich mich recht erinnere, war „/rosen/rot.jpg“ deutlich benachteiligt gegenüber „/rosen-rot.jpg“. In wie weit das auf „normale“ URLs übertragbar ist, weiß ich nicht genau, aber der Dateiname bzw. das letzte Verzeichnis einer URL hat eine gewisse Sonderstellung (wie gesagt, Zwischenverzeichnisse werden im Snippet zum Teil mit /…/ abgekürzt).

Ich würde auf jeden Fall empfehlen, Füllwörter in den URLs wegzulassen:

Statt

lieber .

Bottom Line: Was ist bei langen URLs zu tun?

Die reine Länge der URL ist kein Kriterium, bei dem sich der Aufwand zur Optimierung nachträglich lohnt. Ich würde jedoch bei neuen URLs darauf achten, Füllwörter zu entfernen und einen Fokus auf Hauptkeywords zu legen.

Keyword Stuffing

Hier gibt es eigentlich nicht viel zu sagen. Keyword Stuffing ist das unnötig häufige Wiederholen von Keywords zur Manipulation von Suchmaschinen. Ist veraltet, lohnt sich nicht und sollte nicht gemacht werden. Wenn das bei euch zur Zeit der Fall ist und die Sache „funktioniert“ dann ändert nix an den bestehenden URLs, aber lasst es bei neuen. Wenn ihr generell schlechte Rankings habt, dann wäre das ein Ansatzpunkt zur Ursachenforschung 😉

Beispiel: http://www.example.com/hamburg/mietwagen-hamburg-in-hamburg-mieten-günstig-mietwagen-mieten/

Besser: oder

Keyword Cannibalization

Stellt euch vor, ihr schreibt einen Artikel über 2000 Wörter und behandelt darin ein Thema sehr ausführlich. Das Problem, vor dem ihr jetzt steht besteht darin, dass ihr eine Entscheidung bezüglich der Optimierung eines Keywords treffen müsst, denn Titel und URL sind eben nur begrenzt. Eine mögliche Lösung besteht darin, den Artikel aufzuteilen, so dass ihr in den einzelnen Teilen den Fokus jeweils speziell auf einige wenige Keywords ausrichten könnt. Dabei ensteht zwar eine thematische Überlappung, aber das sollte okay sein, wenn ihr klar definiert, welcher Artikel für welche Keywords ranken soll.

Problematisch wird es dann, wenn das Ganze übertrieben wird. Um also auch das kleinste bisschen Longtail mitzunehmen, wird der Artikel in 20 Teile gesplittet (aufrufbar über eigene URLs), von denen alle ein bisschen was mit einem Thema (aka Hauptkeyword) zu tun haben. Das wird als Keyword Cannibalization bezeichnet und führt meist zu thin/shallow Content. Im Prinzip ist das allerdings kein URL Problem sondern hängt mit tieferliegenden Problemen zusammen (wie gesagt, thin Content…). Ist also auch nix, was man über die URL fixen könnte und ist hier nur der vollständigkeit Halber erwähnt.

Zusammenfassung: SEO URL – best practices

Die wichtigste Message in diesem Artikel mit dem leicht reiserischen Titel Die Wahrheit über perfekte SEO-URLs besteht darin, keine voreiligen Maßnahmen bezüglich der URL Optimierung zu treffen. Bei bestehenden Seiten sind die URLs zwar meist nicht 100%ig perfekt, aber meist können die zu erwartenden Verbesserungen das Risiko, das mit einer Änderung der URL Struktur einhergeht, auch nicht rechtfertigen. Bei neuen Projekten und auch bei neu hinzukommenden URLs bei bestehenden Seiten sollte man aber natürlich darauf achten, von vornherein alles richtig zu machen.

Zu solchen „Mini-Verbesserungen“, deren Änderung sich nicht lohnt, zähle ich zum Beispiel:

- Dateiendung der URL

- Vollkommen egal ob html, php oder einfach ein /

- _ (Underscore) als Trennzeichen

- Klar, sollte man nicht machen aber Google erkennt es weitestgehend trotzdem

- Füllwörter in URLs

- Nicht optimal aber definitiv kein großer Nachteil

- Verzeichnistiefe

- siehe Unstrukturierte URLs

- Subdomain oder Subfolder

- Wenn die Verlinkung innerhalb der Seite gleich bleibt, spielt es keine Rolle und bei Subdomains ist die Administration komplizierter

Mehr fällt mir grad an Mini-Verbesserungen nicht ein, bitte in den Comments ergänzen 😉 Gilt natürlich auch generell: War mein erster Artikel hier, let me know what you think!

Danke für deinen ersten und gleichzeitig sehr wertvollen Gastartikel hier Pascal. Lustig, dass ich mir letzten Sonntag um genau dieses Thema selbst einige Gedanken machen musste.

Schöner Artikel, das mal vorab. Mal eine Kleinigkeit, die aber auch gerne bei Twitter für Probleme sorgt und andere Social-Buttons in der URL-Übergabe auch oftmals ignorieren: /#

Möglichst vermeiden, ein bspw. moebel/stuhl#xyz ist eher weniger ein Problem, die direkte Übergabe aber eher so naja. Vor Kurzem erst hier mal wieder probiert bzw. noch immer: designfalcon.com/#gunnr

PS: Auch Google ignoriert es gekonnt. Eher unpraktisch also dort etwas wirklich sinnvolles unterbringen zu wollen. Ganz davon abgesehen dass es nun einmal am Ende ist.

Cheers, Andi

Hey Andi,

Ich kann mich schwach erinnern, dass ich so ein Problem mal bei der Verlinkung meines Twitter-Accs hatte. Quicktest: !/MySEOSolution (edit: scheint doch zu klappen..)

Anker sind eh ein Thema für sich. Google gibt ja zum Teil Sprungmarken (also Anker) im Snippet an (was für mich ein Indikator dafür ist, dass es auch ins Ranking miteinfließen könnte). Müsste man mal testen 😉

schöner Artikel Pascal, allerdings hast Du einen recht wichtigen Punkt vergessen:

„sprechende URLs“ erhöhen die Klickwahrscheinlichkeit bzw. CTR in den SERPs. Und da die CTR ebenfalls für das Ranking eine Rolle spielen, kann eine optimierte URL schon auch das Züngelchen an der Waage sein, wenn schon der Großteil OnPage optimiert wurde. Deshalb: je kürzer und prägnanter die URL, desto besser. Und um bei der Kombi „Mietwagen Hamburg“ aus Deinem Beispiel zu bleiben: wäre eine „klickwahrscheinlichere URL“ vll. sogar /guenstiger-mietwagen-hamburg.html, auch wenn dort dann die Dichte verwässert wäre. Ich bin der Ansicht, dass das Keywordvorkommen alsl solches weniger Gewicht hat als eine gute CTR.

Beste Grüße

Nico

Hey Nico,

in der Hinsicht „CTR über Keywordfokus“ stimm ich zu. Sind allerdings beides Faktoren, die sich in ihrer Auswirkung nicht wirklich gegeneinander messen lassen (Variante A bekommt 10 Klicks mehr am Tag und Variante B hat dafür ein Wort weniger – darauf eine Aussage über Verbesserungen im Ranking zu machen trau ich mir nicht zu ;))

@Pascal: Danke für den sehr informativen Artikel, da sind echt interessante Gedankengänge dabei 🙂

Was für mich derzeit halt noch nicht von Google’s Seite aussagekräftig ist: hat den die Einführung von der Zuordnung von Parametern mittels Google Webmaster Tools einen SEO-technischen Effekt?

Die Frage stellt sich sicherlich für sehr grosse Verzeichnisse/Shops wo noch zusätzliche Sortierparamter dazukommen, welche nicht immer per Rewrite gelöst werden können. Canonical-Tags sollten hier ja Duplicate Content ausschliessen, aber Google scheint wohl manchmal kräftigst die Seiten zu indizieren. Einfach nicht kontrollierbar, das Biest 😉

Daher die Frage in so einem Fall:

Parametern-URLs für solche Megashop-Seiten so lassen wie sie sind? Und deren Verhalten/Funktionalität in Webmaster Tools einstellen, dann hoffen das Google hier dies dann auch als inhaltlich-releveante Paramter-URLs zuordnen kann?

Die Frage beschäftigt mich gerade und wir versuchen hier auch durch einen längeren Testlauf über einen sehr grossen Webshop Ergebnisse zu erzielen…

@seolobster

Danke 😉

Bzgl. SEO Effekt: Wenn zur Zeit in DC Problem besteht, also auf Grund der Parameter massig Seiten mit dem gleichen Content im Index sind, dann kann das auf jeden Fall ein Problem darstellen. Insofern würde ich auf jeden Fall die Parametereinstellungen nutzen. Hatte bisher allerdings noch keinen Fall, wo ich es konkrete probieren konnte, deshalb leider keine Erfahrungswerte.

Ich denke mal, die „Theorie“ dazu ist dir bekannt? > https://webmasters.googleblog.com/2011/07/improved-handling-of-urls-with.html

Darin werden ja einige Beispiele gebracht.. oder treffen die nicht auf eure Probleme zu?

@Hirnhamster „#!“ funktioniert (jedoch am besten mit statischer Seite dahinter). Das ist sogar eine Vorgabe von Google für dynamische Inhalte (bspw. GWT oder andere Java/AJAX Anwendungen/Scripte). Zwar nicht der Artikel von Google den ich suchte, aber auch passend dazu: https://www.smashingmagazine.com/2011/09/searchable-dynamic-content-with-ajax-crawling/

@Andi

Mir gings eher um ein WordPress problem, bei dem die URL nur vor dem # verlinkt war. Ist aber wie gesagt schon ein Weilchen her, dass ich das Problem hatte.

Aber der Artikel ist interessant, kannte bisher auch nur das Original von Google, ty.

@seolobster

Habe bei diversen großen Shops mit den Parametereinstellungen in WMT gespielt. Bisher sehe ich keine wirkliche Veränderung zu früher. Google scheint die Einstellungen also noch immer zu ignorieren.

Dennoch würde ich soviel wie möglich voreinstellen

Unabhängig vom Thema der Parameter in den GTW (dieses Mal aber die Webmaster Toole, nicht das Google Web Toolkit ;)) … hier vllt. noch der alte Artikel von Google zum Thema URLs und Parameter, nur der Vollständigkeit halber: https://webmasters.googleblog.com/2008/09/dynamic-urls-vs-static-urls.html

Danke für den ausführlichen Artikel…und wieder was gelernt 😉

Schön auch, dass du deine eigene Überschrift als „reiserisch“ beschreibst. Aber ohne diesen Titel hätte ich mir wohl nicht die Zeit genommen 🙂 Auch das muss gekonnt sein, Kompliment 😉

Ursprünglich hieß der Artikel „Das Geheimnis der perfekten URL“ (wenn du dir die URL anschaust, dann siehst du noch das Überbleibsel :/ ). Hab ich btw. vom Sascha Ebach und der akuellen Website Boosting 😉

@Julian & @Hirnhamster:

Die Einstellungen sind schon getroffen worden, bis jetzt aber ist der Effekt doch eher noch mässig bzw. es ist noch wenig in den SERPs zu sehen; freilich bei 70.000+ Seiten kann es schon etwas dauern…. Auch haben wir den Unterschied gemerkt das Google wohl etwas tiefer crawled wenn Parameter da sind.

Wo das ganze eigentlich schon ganz gute Ergebnisse gebracht hat ist bei mittleren Seiten der Ausschluss von SessionID Parametern und ähnlichem, das geht dann doch etwas konsistenter als nur über Wildcard-Robots.txt und Canoncials.

Zum Thema Underscore: Google unterscheidet da durchaus zwischen _ und -.

Keword1-Keword2 wird zum Beispiel als 2 Wörter betrachten, Keyword1_Keyword2 in der Regel als zusammenhängendes Wort.

Also „Keyword1_Keyword2“ kann nur über die Suche nach „Keyword1 Keyword2“ gefunden werden, wogegen „Keword1-Keword2“ auch bei Suchen nach „keyword1“ und „keyword2“ gefunden wird.

Da gab es kürzlich auch ein Video vom Matt dazu, denke nicht das sich das geändert hat, oder?

In der Theorie hast du Recht. Das Video greife ich sogar unter auf und „richtig“ wäre es, keine Underscores zu nutzen.

Und jetzt bitte ich dich, dir mal die URL Struktur von Wikipedia anzuschaun und mir zu bestätigen, das wiki für keine 2-Wort-Suchbegriffe rankt 😉

Beispiel: https://www.google.de/search?hl=de&q=platz%20des%20himmlischen%20friedens

Interessanter Artikel! Ich befasse mich gerade selber mit der Thematik bei meiner eigenen Seite. Angenommen ich setze ich eine ganz neue Website(kein Shop) auf unter aufkleberdruckerei.tld .

Es gibt eine Unterseite „Produkte“, wo dann die ganzen versch. Aufkleberarten beschrieben werden. Wie strukturiere ich nun am sinnvollsten?

1.

aufkleberdruckerei.tld/aufkleber_fuer_autos.html

aufkleberdruckerei.tld/aufkleber_fuer_heckscheiben.hmtl

2.

aufkleberdruckerei.tld/aufkleber/aufkleber_fuer_autos.html

aufkleberdruckerei.tld/aufkleber/aufkleber_fuer_heckscheiben.hmtl

3.

aufkleberdruckerei.tld/produkte/aufkleber_fuer_autos.html

aufkleberdruckerei.tld/produkte/aufkleber_fuer_heckscheiben.hmtl

Ich tendiere zu Variante 1. Allein schon wegen der URL-Länge und da Variante 2 mir zu spammig ist. Und btw. ist es nun besser aufkleber_fuer_autos.html oder aufkleber-fuer-autos.html zu schreiben?

Laut Markus wäre hier die Variante mit den Unterstrichen sinnvoller. Bisher konnte ich aber bei vergleichbaren Seiten nur Ergebnisse mit Bindestrichen oben finden. Zum Beispiel bei „aufkleber drucken lassen“ oder „aufkleber drucken online“. Freue mich auf euer Feedback und wünsche ein schönes Wochenende!

@Hendrik

Also:

1. wenn du die Seite neu aufsetzt, dann verwende „-“ statt „_“

2. Wie oben gesagt wird, gibt es verschiedene Ansichten zur Strukturierung. In deinem Fall würde ich mir die Frage stellen, ob es außer „Aufkleber“ noch andere Produkte gibt. Falls ja würde ich zu (2) tendieren, falls nein zu (1). Aber: das ist pesönliche Präferenz.

3. „fuer“ ist ein Füllwort, das würde ich nicht in der URL verwenden

[…] SEO Scene habe ich (noch nicht) gelesen, wie man die perfekte URL bastelt. Sieht aber ausführlich und ziemlich gut aus. Wobei ich immer wieder davor warne, URLs zu […]

@Markus und @Hirnhamster: Dass angeblich Keyword1_Keyword2 als zusammenhängendes Wort gewertet werden soll, habe ich auch schon gehört, das Beispiel mit dem Platz des himmlischen Friedens ist allerdings sehr schön…. 😉 Generell verstehe ich diese Logik ja sowieso nicht. Schließlich bedeutet ein Bindestrich ja i.a.R., dass die 2 Wörter, die er verbindet, zusammengehören, wohingegen ein Unterstrich in der herkömmlichen Schriftsprache gar nicht vorkommt und in den Anfängen des Internets bei URLs etc. schnell als Ersatz für ein Leerzeichen eingeführt wurde.

Naja denke mal das hängt damit zusammen, dass der Bindestrich auch in Domainnamen das einzig mögliche Trennzeichen ist. Generell sollte es aber egal sein, welches Trennzeichen du nimmst, so lange es eben _nicht_ der Unterstrich ist. Wobei das eben auch kein „richtiger“ Nachteil ist. Trotzdem kein Grund, es bewusst falsch zu machen 😉

Eine Liste der Trennzeichen, die in URLs erkannt werden findest du unter

Vielen Dank für den tollen Artikel und die darauf folgenden Diskussionen. So wie ich das sehe gibt es zwar ein Best Practice aber ob sich das im Ranking wirklich auswirkt bleibt offen.

Hallo!

Das mit den Links ist zwar tatsächlich schöner, für Google… Man weis es nicht.. Nach der Umstellung von php=? links auf .html hatten wir erstmal eine Umstellung, aber gefunden und gelistet wurden wir trotzdem genauso gut.

Eine wirklich tolle und umfangreiche Zusammenfassung. Von nachträglichen Anpassungen an der URL-Struktur würde ich auch abraten, aber bei neuen Projekten sollte man auf jeden Fall darauf achten. Bei den meisten CMS ist das ja eh kein Stress die URLs hübsch zu machen.

Ich glaube sehr wohl, das sich eine gute Url-Struktur auf das Ranking positiv äußert. Wer nach bestimmten Keywords im Web sucht wird wohl eher auf einer Seite landen die es als Bestandteil der Url mitführt, als eine ohne.

Guten Tag,

guter Artikel der bestimmt einigen weiter hilft. Wer WordPress verwendet der sollte unbedingt das Plugin Google XML Sitemaps installieren. Mit diesem Plugin können Einstellungen getroffen werden mit den verhindert wird das duplicate content indexiert wird. z.B Archive, Kategorien, usw. Es sollten nur die Checkboxen – Startseite, Beiträge und Statische Seiten aktiviert sein, damit auch nur diese Indexiert werden. Die Permalink Struktur kann manuell geändert werden. So kann man Füllwörter eliminieren und nur die wichtigsten Keywords in der URL stehen lassen. Außerdem bin ich der Meinung. Je tiefer ein Verzeichnis in der Verzeichnisstruktur liegt, desto unwichtiger wird dies von Google betrachtet. Das kann man alles im E-Book von Google für die Einführung in die Suchmaschinenoptimierung nachlesen. Eine Prüfung eurer Seiten auf Suchmschinenfreundlichkeit solltet hier hier durchführen. Seitenreport. Einfach kostenlos registrieren und im Mehrfachauswahlfeld, Analyse komplett wählen. Ich hoffe ich konnte auch noch ein paar Dinge beitragen.

Viele Grüße Timo Kühne

naja, es glaubt halt jeder an irgendwas. Man kann auch in vielen Worten etwas oder nichts sagen.

[…] Überblick über typische Probleme und mögliche Lösungen bietet der ausführliche Artikel über perfekte SEO-URLs, den Patrick Landau vor einiger Zeit bei SEO Scene veröffentlichte. Ich will das Thema in diesem […]

Anfangs hat die Veränderung der URL-Struktur meiner Google-Bewertung geschadet, aber nicht lange, dann hat es echt was gebracht.

lg DL

Ein fundierter Artikel der sich gut liest, verständlich ist und wenig Fragen offen lässt. Man merkt das dort jemand mit Erfahrung und Sachverstand am Werk war. Mir hat der Artikel geholfen, da ich einen Online-Shop betreibe und mich beim anlegen der URL’s noch im weiteren Aufbau entscheiden kann wie ich weiter vorgehe. Deshalb bedanke ich mich und sage … Weiter so!

@D.Lux: Wie lange hat es denn gedauert bis Google die veränderte Struktur „richtig“ gesehen und bewertet hat? Ich habe nämlich auch ziemlich unvorsichtig meine Permalinkstruktur verändert und stelle seitdem fest, dass es riesige Unterschiede gibt zwischen den ergebnissen in Google Analytics und meiner serverseitigen Auswertung (war natürlich nie 1:1; aber nie so krass unterschiedlich). Alle vorher gesetzten externen Links werden per Plugin zwar umgeleitet, aber meine Beobachtung ist eben auch, dass Google nicht so recht damit klar kommt, wenn von heute auf morgen die Struktur der Permalinks geänder wird.

Naja, vielleicht kann ja einer was dazu sagen?? Danke.

Ich bin auch der Meinung, dass es gerade bei älteren Seiten kritisch ist. Ganz nach dem Prinzip „don´t change a running system“

Die richtigen Keywords in der Url sind sehr wichtig. Gerade für einen Leser (für dem man ja letztendlich optimiert) sticht bei einer Suche die Kewordurl sofort ins Auge und wird normalerweise auch mehr geklickt. Genausowichtig ist auch der passende Titel worauf der User zuerst blickt.

Mit diesem Thema beschäftige ich mich auch schon länger. Ich habe der Einfachheit halber die Endungen .php bzw .html drangelassen, da nach Ihrem Beitrag die Endung irrelevant ist.

Nun aber eine Frage zu den Keywords in in der Url.

Bei meiner folgenden Seite: versichern-auto.de/kfz-steuerrechner.php habe ich das eigentliche Keyword „Kfz Steuer“ und / oder „Kfz Steuer Rechner“.

Nun heißt die Domain aber Kfz-Steuerrechner. Sollte diese dann besser in Kfz-Steuer-Rechner oder in Kfz_Steuer_Rechner, oder vielleicht sogar Kfz-Steuer_Rechner genannt werden für Google?

Aufgrund der „-“ „_“ Regelung würde man damit doch beide Keywords bedienen, oder?

wenn man eine ältere Seite hat kann man nur durch ein paar änderungen wie z.B. javascript, css auslagern, überflüssigen Code entfernen und schon ein paar bessere punkte errecihen. Bei den urls finde ich sollte man das keyword anzielen welches man auch auf der seite später konkret benutzen will

Sehr gute Artikel! ich stehe gerade vor genau dem Problem URLs einer schon lange existierende Seite neu zu strukturieren. Kann mir jemand sagen wir hart es einen bei neuen URLs trifft? Wie lange hält dieser Zustand an? Wenn ich die alten URLs zu den neuen führe (per Link oder direkt auf die neue Seite) laufe ich dann gefahr, dass Google das als DC wertet?

Danke und Gruß, Ray.