Dass aufgrund einer kleinen Änderung bei Google mal wieder der PageRank für tot erklärt wurde ist lustig. Für wesentlich mehr Konsequenzen sorgt weiterhin die Abschaltung der Yahoo API. Schrieb mir doch dieser Tage jemand sinngemäß, dass eine meiner Domains „anstelle einer Domainpop von 400 laut Sistrix nur eine Dompop von 134“ aufweisen würde und unterstellte mir damit Fehlinformation, vielleicht gar Betrug. Ich bin sicher, dass auch andere SEOs diesem Problem verstärkt begegnen. Damit sie dann einfach auf diesen Artikel verweisen können und all die Amateur-SEOs und halbinformierten Entscheider da draussen ein wenig mehr verstehen, an dieser Stelle ein Artikel, der schon seit Wochen geschrieben werden will.

Yahoo ist tot…

Seit die Yahoo API abgeschaltet worden ist, sind vermehrt kostenpflichtige Tools das Mittel der Wahl hinsichtlich der Backlinkanalyse (oder man bohrt SEOQuake auf). Bekannt sind vor allem Majestic und SEOmoz, dazu hat Sistrix seinen Openlinkgraph an den Start gebracht und auch Searchmetrics plant einen großen Wurf.

Am Beispiel des Openlinkgraphs zeigt sich die aktuelle Problematik besonders gut. Es gab eine Phase, als der Openlinkgraph und das Linkmodul der Sistrix Toolbox noch parallel liefen. Das heißt: Ersterer hatte seine eigenen Werte, das Modul basierte noch auf den Yahoo-Werten. Ich checkte eine Anzahl eigener Domains durch und stellte fest, dass die im Openlinkgraph angezeigte Domainpop im Schnitt bei einem Drittel der bisherigen Werte lag. Seit das Linkmodul komplett auf dem Openlinkgraph basiert, ist dadurch die Domainpop vieler Domains massiv gesunken.

Johannes hat folgerichtig einen Schnitt gemacht und die bisherigen Linkwerte in ein Archiv verfrachtet, da die Datenentwicklung ansonsten nicht mehr sinnvoll vergleichbar gewesen wäre (wenn der Crawler allerdings tiefer gehen sollte, würde die Domainpop nur deshalb steigen, weil mehr Links erkannt werden, nicht weil sie neu aufgebaut wurden).

Ich monitore bei Sistrix beispielsweise die wichtigsten Seiten im Bereich Gutscheine und sehe dort aktuell Einbrüche in der Domainpop zwischen 43 und 82%! Da der Openlinkgraph mir allerdings beim Gegencheck höhere Werte auswirft, gehe ich davon aus, dass aufgrund der aktuellen Umstellungen noch nicht alle Werte zwischen den Modulen korrelieren, was sicher bald korrigiert ist. Insofern bleibe ich mal bei dem oben angegebenen Drittel.

… es lebe Yahoo!

Diese Verminderung der Linkwerte bedeutet nicht, dass die Werte von Sistrix schlecht wären, zumal sie hervorragend aufbereitet sind und viele wertvolle Zusatzinformationen bieten, die die reinen Yahoo-Linkdaten nicht besitzen.

Es ist einfach nur das, was schon seit vielen Jahren gilt: Kein Tool der Welt zeigt einem wirklich alle existierenden Backlinks an. Auch Yahoo lag nicht bei 100% (allein schon die Seiten, bei denen SEOs den Bot ausgeschlossen haben *g*), war aber schon recht umfassend. Moment, kein Tool der Welt? Doch, es gibt ein Tool, das alle wirklich relevanten Backlinks anzeigen sollte: Die Google Webmastertools. Fragt mich jetzt nicht nach den Bing Webmastertools, ich hab sie immer noch nicht getestet – aber wenn Bing die Yahoo-Daten verwertet, dürfte die Tendenz klar sein. Das Problem ist nur, dass man die Webmastertools

- nur für eigene Seiten verwenden kann,

- sie nicht die ausgefeilten Möglichkeiten bieten wie beispielsweise der Openlinkgraph, man also den Export nachbearbeiten müsste, und

- auch Google mittlerweile zu filtern scheint. „Die 462 beliebtesten Seiten, die Links zu Seiten auf Ihrer Website enthalten“ sehe ich bei einem Projekt, das aktuell laut Yahoo eine Domainpop von 674 und laut Sistrix von 522 hat. Da sind die Webmastertools also sogar schlechter. Tja, wie definiert Google „beliebt“? 😉

Wieso ich eine aktuelle Domainpop von Yahoo angebe? Auch wenn die API offiziell abgeschaltet wurde, bedeutet dies nicht, dass Yahoo keine Daten mehr liefert. Solange der Siteexplorer läuft, kann man praktisch weiterhin seine Ergebnisse scrapen. Dies funktioniert allerdings nicht bei größeren Seiten wie Wikipedia oder SPON, weshalb diese Methode für professionelle Toolanbieter kaum in Frage kommt. Erst wenn der Siteexplorer dieses Jahr endgültig das Zeitliche segnen dürfte, ist auch hier Schluss mit lustig. Totgesagte leben bekanntlich länger, aber nicht zwangsläufig ewig.

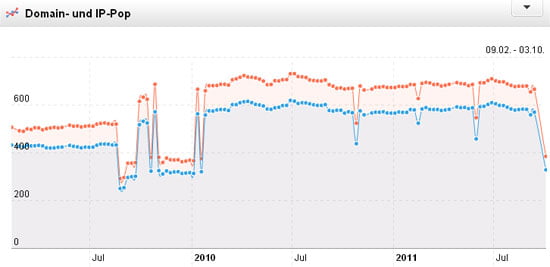

Das Archiv der Sistrix Domainpop - Man sieht deutlich die Einbrüche, wenn die Yahoo Werte mal nicht zur Verfügung standen bzw. den Absturz am Ende.

Welche Links soll man sehen?

Auf der dmexco hatte ich mit Johannes dazu ein längeres Gespräch. Er hat ja schon früher eine gewisse Filterung der Daten kommuniziert: Man muss nicht jeden dmoz-Clon und schlecht gepflegten Webkatalog sehen. Soweit ich sehe, sind von der neuen Reduktion der Daten vor allem schwache Links betroffen. Muss man wirklich die fünfte Ebene der Kategorie eines Social Bookmark Dienstes sehen?

Pro Reduktion

- wenig relevante Linkdaten fallen weg

- bessere Übersicht über relevante Linkdaten

- geringere Crawl- und Serverkapazitäten nötig

Contra Reduktion

- auch sehr schwache Links generieren in der Masse eine Wirkung

- bessere Erkennung von BlackHat-Maßnahmen (Spam-Linkattacken durch XRumer etc.)

- erschwerte Kommunikation der Linkdaten gegenüber Kunden

Was ist eure Sicht dazu?

Fazit

Aktuell ist ein Überblick über Werte wie Domainpop schwierig geworden. Wenn mir beispielsweise Sistrix bei Domains im Schnitt nur noch 30% der alten Werte anzeigt, aber laut eigenen Angaben zumindest im deutschsprachigen Bereich noch etwas besser ist als Majestic und SEOmoz, wäre dann eine Zusammenführung der Werte hilfreich? Sicher, man könnte dies tun (was wohl preislich eine Herausforderung wäre) und ein Tool wie Cempers Linkresearchtools dafür nutzen. Doch die Zusammenführung ergäbe – selbst wenn jedes Tool bei 30% läge – keinesfalls 90%, da der überwiegende Teil der Links Dubletten wären. Was käme also insgesamt heraus? 60%? 50%? Gar nur 40% der bisherigen Yahoo-Daten?

Insofern wieder meine übliche Botschaft: Tools sind geil und professionelles SEO ist heutzutage ohne Unterstützung durch Tools reines Glücksspiel. Gleichzeitig sollte man – wie schon in meinem Artikel über den Sistrix Sichtbarkeitsindex gezeigt – bei der Benutzung von Tools nicht sein Hirn abschalten. Letztendlich ist jedes Tool nur so gut, wie der der es nutzt. Also, liebe Amateur-SEOs und halbinformierte Entscheider: Wenn ihr plötzlich niedrigere Werte hinsichtlich der Domainpop seht, dann heißt das nicht zwangsläufig, dass es da draußen keine anderen Links zu diesem Projekt mehr gibt…

Nach Yahoo jetzt auch Google. Bei mir wird überhaupt kein PR mehr angezeigt. Seit gestern. Hast du da was mitbekommen?!

Tja, das Weglassen der „schwächeren“ Links ist natürlich eine sehr kritische Praxis bei Sistrix. Imo gehören die auch zu einem guten Linkprofil und wenn man seine Mitbewerber analysieren möchte, dann muss ich die einfach auch sehen. Schließlich gilt es zu schauen, auf welche Strategie die setzen, welches BL-Profil die haben. Da reicht es nicht, wenn ich nur die vermeintlich stärkeren sehe, aber nicht weiß, was und wie er im unteren Bereich vorgeht. Wäre es denn für Johannes nicht möglich gewesen, die Yahoo-BL-Daten (die er ja sicherlich für abgefragte Domains in der DB hat) mit in den neuen Crawler zu packen oder zumindest zusätzlich anzuzeigen? Ich finde den krassen Schnitt leider grad nicht so gut.

Nachtrag: Gerade eben hat Xovi auf hingewiesen. Die oben angeführte Domain weist hier eine Yahoo Domainpop 873 aus, also deutlich mehr als alle anderen Tools ermitteln konnte. Eine Überprüfung unter „Backlinkcheck“ legt allerdings die Vermutung nah, dass viele Backlinkdomains mehrfach gezählt worden sind, also eher Linkpop denn Domainpop angezeigt wird. Aber okay, das Tool ist noch beta. Auf jeden Fall geschieht einiges am Markt.

Hatte Domainvalue von Xovi auch kurz getestet. Die Werte sind nicht schlecht, aber vertrauen würde ich darauf erst, wenn ich alle Quell-URLs sehe.

@Mitch

Der Pfad zur Pagerank API wurde von Google geändert, von daher wird bei dir nichts angezeigt. So habe ich es zumindestens auf Twitter gelesen. Aber wäre schön, wenn es ihn nicht mehr geben würde 😉

Du sprichst mir aus der Seele. Mit Yahoo hab ich durch „clevere“ Abfragen eine Domainpop von ca. 2000 erreicht. Sprich die Daten sind ja da, bloß konnten wir aufgrund der 1000 Limitierung nicht auswerten. Majestic ist wohl im Euro Raum besser als Seomoz und Johannes wohl besser für DE. Majestic ist halt noch verwirrend wegen dem fresh und historic Index.

Mal gespannt was Searchmetrics raus haut. Aber die Historie fehlt auch hier.

Johannes crawlt ja 4,2 Milliarden Seiten – wahrscheinlich bräuchte er aber das doppelte um die Yahoo Daten gänzlich zu ersetzen. Wobei wie gesagt – Johannes auf jeden Fall gezielter crawlt und z.B. nicht jede Amazon Unterseite anfasst.

Bis jetzt bin ich mit dem openlinkgraph ganz zufrieden. Zwar fehlen auch hier noch eins zwei sinnige Filterfunktionen (Bsp. Seitenweite Links), aber kein Tool ist von Start an perfekt.

Gespannt bin ich – ebenso wie Tom – auf die Daten von Searchmetrics. Mit Essentials wurde hier meiner Meinung nach schon ein guter Schritt im Bereich Handhabung und Darstellung getan. Wenn nun der Backlinkbereich auch noch ein richtiger Hit wird, wird es denke wieder etwas interessanter auf dem SEO-Tool Markt.

Finde als alternativen Backlink-Checker ebenfalls recht brauchbar. Die schwächeren Links, die Yahoo füher ausgespuckt hat, sind meines Erachtens eher vernachlässigbar, da diese sowieso zumeist freiwillig kommen.

Hallo Frank,

schöne Zusammenfassung der aktuellen Lage. Ich habe mir den OpenLinkGraph jetzt oberflächlich, bei weitem noch nicht ausführlich, angeschaut. Grundsätzlich gefällt mir erst einmal die Aufbereitung der Daten, was für mich ein wichtiger Faktor für ein Tool ist, denn wenn die Daten schlecht aufgearbeitet sind (also die Darstellung eher unübersichtlich ist), dann kann ich mit dem Tool nicht arbeiten.

Ich habe in den letzten Wochen gemerkt, dass einige Firmen, weltweit, an einem Backlinktool arbeiten. Das größte Problem am OpenLinkGraph ist, dass die Datenbank noch wenige internationale Links (aus Indien, China, den USA, Canada oder Brasilien) enthält, da es ist halt sehr auf Deutschland fixiert. Da man aber nicht nur Links aus dem deutschsprachigen Raum bekommt, ist das natürlich noch suboptimal, aber ich denke die Tools sind auf einem guten Weg.

Gespannt bin ich auf das Backlinkmodul von Searchmetrics. Die Tools von Marcus sind natürlich grundsätzlich schon einmal internationaler aufgesetzt und ich glaube das Marcus da gute Daten anbieten wird und mit Searchmetrics Essentials haben sie bewiesen, dass sie Daten gut aufarbeiten können.

Ich halte eigentlich nur eine Lösung für die optimale Lösung (optimal im Vergleich zu den anderen Möglichkeiten) und zwar die Aggregation von Daten aus den weltweit größten Tools. Wie du schon sagst, die meisten Einträge werden doppelte Einträge sein, aber dadurch dass man sehr viele Daten, auch von spezialisierten Anbietern aus gewissen Ländern beziehen würde, würde ein gutes Gesamtbild entstehen.

Grüße,

Justin

Die Frage ist ja, ob die Zahlen von Yahoo überhaupt stimmen bzw. gestimmt haben. Waren die Ergebnisse wirklich aktuell? Der aktuelle Test von Suchradar zeigt, dass die meisten Tools viel zu viel alte Links anzeigen, die es in Wirklichkeit überhaupt nicht mehr gibt. Ein Tool einfach nach der Anzahl gefundener Links/Domains zu bewerten macht daher überhaupt keinen Sinn. Hier der Test von Suchradar:

Ganz klar gewonnen hat den Test übrigens der OpenLinkGraph von Sistrix. MajesticSEO hat zwar die meisten verlinkenden Domains gefunden, davon enthielten nach Überprüfung aber über 70% nicht mehr den Link. Wahrscheinlich ist es auch bei Yahoo immer so gewesen, dass überwiegend nicht mehr existierende Links angezeigt wurden. Das ist natürlich schwer zu überprüfen, da man bei Yahoo bei größeren Mengen eigentlich nie alle Links exportieren konnte (noch so eine Schwäche von Yahoo).

Ich warte eigentlich auch noch darauf, dass jemand mal eine Applikation zur Verfügung stellt, die sämtliche Daten aggregiert. Bin mir nicht ganz sicher, wie das bei den Link Research Tools gemacht wird, also ob da tatsächlich erstmal alle Links gezogen werden um diese dann als „neue“ Basis zu verwenden.

Der Fokus auf DE ist sicherlich für Deutschland wichtig, aber gerade wenn es Richtung Spam/Blackhat geht, überwiegen internationale Backlinks recht stark – um sowas sinnvoll zu erkennen und analysieren zu können, kommt man um diese Daten nicht herum.

Bin auf jeden Fall mal auf die Lösung von Searchmetrics gespannt..

Grüße

Pascal

Der Anzeige PR funktioniert aber schon seit einigen Tagen nicht mehr und diesbezüglich gibt es weiterhin Tools, die dir den PR anzeigen.

Zum Beispiel den Fake Pagerank.

Grüße

Passend zum Thema möchte ich auf diesen Artikel der Internetkapitäne hinweisen: Link-Datenbanken im Vergleich

Herzlichen Dank für die Insights, spannend ist nun, wie die Linkverkäufer darauf reagieren, wenn man keine validen Qualitätskriterien aktuell hat!

Schöne Zusammenfassung, ich finde den Openlinkgraph schon mal einen guten Ansatz aber es sollten auf jeden Fall auch die lowlevel Links mit einbezogen werden. Denn wie schon geschrieben wurde gehören diese in einen Mix mit rein. Man braucht auch einfach diese Links für eine gute Auswertung, denn es könnte schon sein das genau diese Links den kleinen Ausschlag über die bestimmten Rankings in Nischen geben.

Es ist schon bedenklich, wenn der Wegfal einer API sämtliche Tools ausser Gefecht setzen kann. Dabei war doch absehbar, dass die Siteabfrage für Yahoo nur Kosten und keinen zielführenden Traffic verursacht (die Klientel konvertiert nunmal nicht) und daher irgendwann abgeschaltet wird. Hätte man hier mal nachhaltig und weniger gewinnorientiert („Ich habe die Technologie, die ihr braucht!“) überlegt, hätten die großen Toolbetreiber sich schon im Vorfeld zusammen setzen können, um an einer Lösung zu arbeiten. Sicherlich ist hier niemand in die Pflicht zu nehmen und jeder ist sich selbst der nächste, aber ich würde es mir von der Szene einfach wünschen. Bei all den wirklich klugen Köpfen… monopolorientiertes Wettrüsten?

Marius, angesichts der vielen kostenpflichtigen Tools habe ich mich schon gefragt, ob sich eine entsprechende Strategie für Yahoo nicht hätte lohnen können. Vermutlich für den Konzern selbst zu marginal, aber da die Daten ja vorliegen, wäre eine kleine, schlagkräftige Ausgründung vielleicht interessant gewesen.

[…] die Mehrzahl an Links ist, die über Majestic SEO gefunden werden. Frank Doerr berichtet auf SEO-Scene.de über ein Gespräch mit Johannes von Sistrix, der eine gewisse Filterung der Daten kommuniziert. So […]

Hallo Frank,

gerade dein Statement im Fazit, nämlich dass „halbinformierte Entscheider“ (super :)) keinen Zugriff auf SEO-Tools haben sollten, weil sie überhaupt nicht mit den erhobenen Kennzahlen umgehen können, kann ich vollkommen unterschreiben. Bei einigen unserer größeren Kunden hat die GF-Ebene Zugang zu Sistrix oder anderen Tools. Mit steigenden Kurven wird bei den Stakeholdern angegeben und bei stagnierenden oder gar sinkende Sichtbarkeiten wird unabhängig vom tatsächlichen organischen Traffic, den man beispielsweise mit Webanalytics erheben könnte, eskaliert.

Das ist echt ein Problem bei größeren Unternehmen, die SEO betreiben lassen.

Danke für den tollen Post!

Axel

Hallo Axel,

ich sage nicht, dass Amateure oder halbinformierte Entscheider keinen Zugriff haben sollen. Mein Credo ist: Jeder der Zugang hat, sollte über genug Wissen verfügen, die Zahlen sinnvoll interpretieren zu können. Denn ansonsten tritt all das ein, was du beschrieben hast.

1. Es muß „abgeschaltet“ heißen.

2. Die Schnittstelle kann nach wie vor genutzt werden und läuft.

3. Ein Moderator sollte wissen was er sagt, sonst kommt das irgendwie nicht wirklich kompetent rüber.

Hi Frank,

prima Artikel – da werde ich meine Entscheider hin verweisen, falls das Thema auftaucht. Andererseits sind meine Kunden „gut erzogen“, vielleicht wird´s gar nicht notwendig 😉

Für größere Domains liefern tatsächlich mehrere der angesprochenen Tools halbwegs brauchbare Werte. Momentan favorisiere ich unter den Alternativen noch Majesticseo … mal schauen was Johannes oder Marcus noch auf die Beine stellen, momentan wäre ich zumindest mit dem OLG eher nicht happy, da mir die internationalen Links wichtig sind …

Sobald es aber an Domains unter DP 500 (letztlich sehr oft das, was den normalen Endkunden betrifft & im Siteexplorer relativ umfassend ist – verstehe gar nicht, warum bei BL-Tool Vergleichen bisher meist überproportional viele „fette Domains“ wie spiegel.de analysiert/verglichen werden?) geht, habe ich bisher leider auch noch keinen adäquaten Ersatz für die Yahoo „Pseudo-DP“ Abfrage gefunden, bzw. werde mir wohl, sobald Siteexplorer scrapen nicht mehr geht, die Daten von mehreren Tools zusammen führen müssen …

Glücklich, wer für seinen Datenbestand zum zukünftigen grabben alle Y! BLs hat, ansonsten wird´s mit der Expired Bewertung demnächst ein ziemliches „stochern im Nebel“ 😉

Grüße aus Berlinien!

Frank

Der direkte Vergleich diverser Tools hinsichtlich ausgewählter Domains ist nmE einigermassen sinnfrei, denn letztendlich basiert die Arbeit von Spidern auf dem Zufallsprinzip.

Insofern muß man entscheiden, welche Daten man wirklich braucht.

Für mich haben sich auf lange Sicht sistrixund xovi als nützlich erwiesen, hinzu kommt jetzt noch seolinktool weil die Spider da anscheinend etwas anders hinsichtlich der Gewichtung programmiert sind und deutsche Seiten stark berücksichtigt werden.

Abschliessend bleibt ja noch der Schluß, daß, egal, wie viele Tools man benutzt niemals das Bild herauskommt, das Google letztendlich für seine Bewertung hat…

Interessanter Beitrag nebst Diskussion. Wichtig bei all den Tools ist wohl vor allem die Zusammenführung, Auswertung und Pflege der Daten, welche – wie ich den besuchten Konferenzen entnehme – sich jede bessere Agentur in ihr eigengenutztes SEO-Tool programmiert hat. Nur so kann man effizientes Linkbuilding (respektive Nachbau von Linkportfolios) betreiben.