Automatisierung ist im Bereich der Suchmaschinenoptimierung nichts Neues. Viele Größen arbeiten bereits seit Jahren damit. Gleichzeitig entwickelt sich dieser Bereich aus meiner Sicht immer weiter – 2009 war hier mit dem zunehmenden Angebot zahlreicher SEO-Tools auf dem deutschsprachigen Markt eine ganz neue Qualität spürbar. Neben meinen Beobachtungen und Einschätzungen basiert dieser Artikel auf vielen Gesprächen mit hochqualifizierten SEOs, die ich grade im letzten Jahr zum Thema Automatisierung führen durfte.

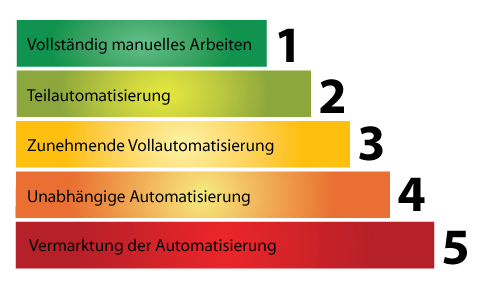

Stufen der Automatisierung am Beispiel Monitoring/Reporting

Als ein Kunde vor ca. zwei/drei Jahren zu mir kam, führte er den Bereich Monitoring/Reporting vollständig manuell aus. Er surfte Google an, gab sein Keyword in den Suchschlitz ein, durchsuchte die Ergebnisseiten (schlimmstenfalls bis Seite 10) danach, wo seine Seite auftauchte. Das Ergebnis wurde in einer Textdatei protokolliert und dann begann das Procedere von vorn, bis alle Keywordkombinationen durchgetestet waren.

Die zweite Stufe, die Teilautomatisierung, erreichte er damals, als ich ihm den kostenlosen Google Monitor empfahl. Die Kombinationen wurden einmal manuell angelegt und immer, wenn ihm danach war, stieß er die Überprüfung an. Das Tool checkte automatisch und protokollierte die Veränderungen. Viele Hobby-SEOs nutzen den Internet Business Promoter, der ähnlich funktioniert, aber dazu noch ein Reporting erzeugt.

Auf der dritten Stufe würde sich das Ganze immer mehr der Vollautomatisierung annähern. Nehmen wir das Modul Monitoring aus den SISTRIX Tools. Die von mir angelegten Suchbegrifsskombinationen und Domainwerte werden automatisch jeden Tag gecheckt und je nach Einstellung des Reportings täglich, wöchentlich oder monatlich direkt an meine Kunden bzw. mich per Mail versendet. Sobald die Abfragewerte im System angelegt sind, arbeitet es weitgehend automatisch. Allerdings muss ich noch immer die Abfragen händisch Stück für Stück ins System eingeben, mit den Beschränkungen des Interfaces leben und Änderungen manuell einführen. Würde mir das Tool eine angegebene Domain selbständig analysieren, die Übernahme von passenden Suchbegriffen ins Monitoring anbieten bzw. selbständig durchführen, dito im laufenden Prozess dies ständig optimieren, würde der Grad der Automatisierung beständig gesteigert. 100%ige Automatisierung ist nur in Teilbereichen möglich, dazu weiter unten mehr.

Bis hierher arbeitet man mit externen Anbietern. Level 4 würde für mich bedeuten, eigene Tools zu entwickeln und einzusetzen. Man ist unabhängig von anderen Anbietern und muss ihnen keinerlei Datenmaterial in die Hand geben. Anpassungen an den eigenen Workflow sind möglich. Kennzeichen von Level 4 ist also nicht unbedingt der Grad der Automatisierung, sondern vor allem Unabhängigkeit und Skalierbarkeit.

Der höchste Level ist erreicht, wenn die Qualität der Tools so gut sind, dass man sie kostenpflichtig anderen SEOs anbieten kann. An dieser Stelle muss man weniger das Tool selbst automatisieren, sondern vielmehr die Vermarktungsprozesse. Der Anbieter verlagert damit automatisch seinen Schwerpunkt vom SEO-Dienstleister zum Dienstleister für SEOs. Bestes Beispiel 2009 ist für mich die SISTRIX GmbH. Johannes arbeitet nicht mehr mit Kunden, die SEO benötigen, sondern liefert SEOs das, was sie brauchen. Er hat eine Meta-Ebene erreicht und sein Geschäftsmodell verändert.

Automatisierungs-Pyramide

Hier das Ganze noch mal überschaubar. Mir fehlt die Zeit, es als Bild zu basteln, darf aber gern jemand für mich tun und es mailen 🙂 Edit: Thanks an Bernd Leitsoni für die Grafik:

Aufteilung und Ausmaße von Automatisierung

Das Zeitalter der Industrialisierung brachte uns die zunehmende Automatisierung. SEO lässt sich in einige Hauptbereiche aufsplitten und diese wiederum in zahlreiche Einzelschritte. Ein SEO kann beispielsweise im Bereich Monitoring einen hohen Grad an Automatisierung erreicht haben, notiert aber die für seine Kunden aufgewendeten Stunden immer noch auf ein Blatt Papier, zählt diese am Ende des Monats zusammen und tippt dann seine Rechnung.

Ähnlich im Bereich Linkbuilding. Ein einfacher Webmaster verlinkt sich mit jemandem, freut sich darüber und hakt es ab. Auf höherer Stufe wird jeder einzelne Backlink dokumentiert, seine fortlaufende Existenz automatisch überwacht und das Ganze wiederum mit Monitoring gekoppelt, um die Wirkung zu sehen. Im Extremfall hätten wir einen SEO (ich konstruiere mal ein dämliches Beispiel *g*), der folgendermaßen vorgeht: Seine Tools ermitteln die interessantesten und trafficstärksten Keywordkombinationen für ein definiertes Projekt, erzeugen auf dieser Basis automatisch Texte, die in automatisch generierten Seiten online gehen, deren Ranking automatisch überwacht wird, wo automatisch Links generiert oder über Dienste Links eingekauft werden, deren Wirkung überwacht und deren eventuelle Kosten automatisch beglichen werden. Der SEO kann die Zeit dann in andere Arbeiten investieren oder sitzt sein kaltes Bier schlürfend am Strand von Teneriffa und schaut nur noch ein Mal im Monat auf seinen Kontoauszug.

Produktivität vs. Qualität – Nachteile und Grenzen von Automatisierung

Dieses letzte Beispiel zeigt ganz deutlich, wo die Nachteile liegen können. Automatisierung steigert die Produktivität, ganz klar. Je mehr ich automatisiere, desto mehr Zeit habe ich, die ich in Prozesse investieren kann, die nicht oder nur schwierig automatisiert werden können. Doch bin ich der Ansicht, dass keine Maschine und kein Programm eine Arbeit so gut machen können, wie ein qualifizierter und aufmerksamer Mensch. Ob eine Positionierung in den SERPs von einer Software oder einem Menschen überwacht werden, macht qualitätsmäßig im Grunde keinen Unterschied. Aber ob ein Text von einer Software oder einem Menschen verfasst wird, schon. Sicherlich kann man auch mit Maschinentexten ranken, doch ist spätestens beim Besuch eines Quality Raters Schluss.

Letzteres zeigt auch Googles Dilemma: Google setzt aufgrund der riesigen, zu bewältigenden Arbeit massiv auf Software. Algorithmen sollen weitestgehend Probleme lösen, nicht Menschen. Doch muss auch Google erkennen, dass in bestimmten Bereichen menschliche Intelligenz nötig ist. Ein Mensch kann auf einen Blick eine Fake-Seite erkennen, die der Algo vielleicht bestens bewertet.

Doch selbst beim Monitoring kann ein menschlicher Blick hilfreich sein. Ein manueller Check mag mich z.B. darauf aufmerksam machen, dass sich eine neue Seite interessant nach oben bewegt, ein Blick ins Impressum zeigt mir, dass ich den Betreiber kenne und eine kurze eMail bringt dann einen wertvollen Linkaustausch mit sich. Doch insgesamt gesehen ist so etwas schon eher Luxus, ein kleines AddOn zum automatisierten Monitoring.

Jeder SEO muss also selbst entscheiden, wo er Automatisierung sinnvoll einsetzen kann und muss und in welchem Grad er es tut. Insofern sind SEOs im Vorteil, die über Programmierkenntnisse verfügen bzw. gute Programmierer im Team haben. Alternativ müssen entsprechende Dienstleistungen eingekauft werden. Ohne Automatisierung geht es im Profibereich jedenfalls schon lange nicht mehr. Und zwar längst nicht nur im BlackHat/Spam-Bereich, wo Automatisierung extrem stark vertreten ist, sondern auch im WhiteHat-SEO.

Durch das Automatisieren von Prozessen ermöglicht man zwar auf der einen Seite die Arbeitserleichterung für Profis, gibt aber ungeübten Optimierern Arbeitsabläufe vor. So mussten SEOs früher eigene Arbeitsschritte entwickeln, durch den im Markt frei zugänglichen Automatisierungen und damit Arbeitsprozessen wird der Einstieg für jeden erleichtert. Das führt meiner Meinung dazu, dass es mehr und mehr SEOs geben wird, die Ihre Dienste besser nicht Kunden anbieten sollten.

Hallo,

beim Begriff Automatisierung fällt mir spontan die autom. Contentgenerierung bzw. deren Einstellung auf unterschiedlichen Plattformen ein. Beides, insbesondere das gleichzeitige Einstellen z.B. auf Twitter, Facebook und Xing mit absoluter Sicherheit auf Dauer ein Schuss in den Ofen…

Grüße

Gretus

Hi Gretus,

hab deinen Kommentar jetzt erst im Spam entdeckt und befreit. Interessanterweise sprichst du etwas an, das ich ursprünglich mit reinnehmen wollte, aber dann gelassen habe, um den Artikel nicht zu überfrachten. Ich persönlich mag es, wenn Twitter-News von mir automatisiert direkt in Facebook erscheinen. Mir fehlt die Zeit, beides individuell zu gestalten, aber ich erreiche in Facebook einfach nochmal andere Freunde und Kollegen als via Twitter. Insofern sehe ich bislang nur Vorteile.

diese scheiß rt in den kommentaren. ist ja ganz toll zu zeigen, dass bei twitter ein paar den post verlinken, aber hat überhaupt kein mehrwert.

warum trennst du nicht wenigstens echte kommentare, trackbacks/pingbacks und tweets?

das ist echt eine nervige entwicklung in vielen blogs.

HAb ich schon gesagt, dass ich Tweets in Blog Kommetaren hasse ? Nee, dann sag ich es hier.

Jetzt zu deinem Post, den ich extrem klasse finde. Ich glaube, dass sich durch die von dir beschriebene Spezialisierung in der Zukunft in der Tat einiges bewegen wird. Ich teile mit dir aber nicht die Auffassung, dass man alles automatisieren sollte. Gerade automatisierte Kundenreports sind totaler Schrott. Im Consulting sind Strategiepunkte und Schlussfolgerungen das A & O. Da kann ich keinem Kunden einfach die Reports um die Ohren hauen. Es geht darum Milestone zu fixen und zu beschreiben. Gleiches gilt für Betreuungsverläufe.

SEO ist in der Spitze professioneller geworden und das wird in der Zukunft dazu führen, dass es immer mehr speziell angepasste Agenturlösungen geben wird. Und diese Agenturen werden ein Teufel tun und das Know How in die Breite streuen. Die Kunst wird es eher sein, die Sachen save zu halten.

Einen großen Markt sehe ich bei den Datenabietern von Crawlingdaten. Da wird es Bewegungen geben. In Zukunft werden gute SEO Agenturen nur noch die Rohdaten kaufen und dann für sich angepasst weiterverarbeiten, da der logistische und finanzielle Ansatz für breites und tiefes Crawling zu groß für einige sein wird.

Un din Zukunft wird eines auch ganz wichtig sein. Wer kennt wen.

Nur wenn du gute Kontakte hast, wirst du an Daten, Personal und Strukturen kommen, die dich sicher nach vorne bringen.

Bedeutet, da zieht Automatisierung garnicht, sondern, das muss jeder schon immernoch selber bringen. Von den Einsparpotentialen im Bereich personal networking deals will ich garnicht reden.

Aber danke für den Denkanstoß.

Okay, hab das Feature erstmal deaktiviert für neue Postings. Wenn jeder meckert, bringt es nichts. Und eine saubere Lösung zur getrennten Darstellung müsste ich hier erstmal implementieren, dazu fehlt die Zeit. Und hey, sind auch viel zu viel ausgehende Links auf der Seite 🙂

@Steffen: Die Gefahr kann ich derzeit nicht erkennen. Genauso besteht die Möglichkeit, dass ungeübte SEOs auf Dinge stoßen, die ihnen sonst nicht bewusst gewesen wären.

@Marco: Hinsichtlich eines Consultings hast du sicherlich Recht. Die Auswertung von automatisch aggregierten Daten und die Kommunikation der Schlussfolgerungen und Strategien braucht den Blick eines Fachmanns.

[…] Automatisierung und SEO, zwei Begriffe die man auf einem seriösen Niveau meiner Meinung nach vor 3 bis 4 Jahren noch nicht wirklich gut verbinden konnte. Heute kann man SEO und Automatisierung ohne Sorge in einem Satz erwähnen, sollte aber ggf. auf skeptische Blicke älterer Kunden eingestellt sein. In die Tiefe möchte ich nicht weiter gehen, lest bitte beim – meiner Meinung nach – gelungensten SEO-Simpson der Szene nach: SEO und Automatisierung. […]

Interessanter Artikel!

In der Blackhat-Szene hat sich wie schon erwähnt die Automatisierung durchgesetzt, odrt wird mehr auf Masse als auf Qualität gesetzt.

Es werden sog. Autoblogs aufgesetzt, die automatisch Content scrapen, posten, die Posts auf Twitter veröffentlichen, relevante Tweets, Bilder (flickr), Youtube-Videos anzeigen und Linkbuilding durch Social-Bookmarking-Massen-Add Dienste wie onlywire und WP-Plugins wie PingCrawl betreiben. Ich denke ich werde zu dem Thema in nächster Zeit selbst einen Artikel veröffentlichen, denn das Thema ist äußerst spannend und wird immer aktueller.

Gruß

Filip

[…] SEO und Automatisierung (seo-scene.de) […]

[…] habe vor ein paar Tagen auf SEO Scene das Tool Free Monitor for Google wieder entdeckt. Mit dem kleinen Programm kann man recht einfach, […]

Guten Abend,

Meiner Meinung nach ist es noch halbwegs unkritisch, wenn man Meldungen auf Twitter und auf Facebook im gleichen Wortlaut absetzt.

Aber grundsätzlich kann auch das mit sehr wenig Aufwand einfach vermieden werden, schließlich bietet Facebook Platz für mehr Zeichen – entsprechend sollte man diesen auch ausnutzen!

Für den Fall aber, dass man mehrere Microblogging-Dienste und Social-Media Accounts verwendet, um auf möglichst vielen Kanälen präsent zu ein, sollte man jedoch tunlichst darauf achten, dass…

1) … der Content der Meldungen auf den verschiedenen Plattformen ausreichend variiert und sich voneinander abhebt

2) … die Verlinkung von eigenen Blogbeiträgen und PR-Meldungen über Social Media Plattformen zeitlich nicht zur gleichen Stunde stattfindet, sondern idealerweise über die Folgetage und -wochen verteilt wird. So etwas kann problemlos halbautomatisch gesteuert werden.

Ansonsten ist die vollständige Automatisierung immer dann sinnvoll, wenn große Datenmengen erfasst werden müssen, was auch für das Reporting von Kennzahlen gilt.

Die detaillierte Auswertung und Strukturierung der Rohdaten & KPIs kann jedoch bei einem derart komplexen Thema wie SEO grundsätzlich nur durch ein oder mehrere helle Köpfchen geleistet werden, da viel zu viele Faktoren in die Analyse einbezogen werden müssen.

Da außerdem die Rankings täglich in Bewegung sind findet man in den SERPs (wie oben im Beitrag treffend beschrieben) immer wieder neue, gute Gelegenheiten für Kooperationen, die kein Tool auf der Welt hätte zustande bringen können.

Mein Fazit:

Automatisierung gerne… jedoch flankiert durch Verstand, Intuition und Bauchgefühl 🙂

Gruß,

Sebastian